Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

Tags

- type hints

- Numpy data I/O

- dtype

- 최대가능도 추정법

- python 문법

- Python

- Comparisons

- VSCode

- Operation function

- subplot

- 딥러닝

- 표집분포

- Numpy

- Python 특징

- linalg

- BOXPLOT

- unstack

- groupby

- pivot table

- 정규분포 MLE

- scatter

- Python 유래

- ndarray

- 카테고리분포 MLE

- boolean & fancy index

- 부스트캠프 AI테크

- seaborn

- namedtuple

- Array operations

- 가능도

Archives

- Today

- Total

또르르's 개발 Story

[Stage 3 - 이론] DST의 Computational Complexity 본문

DST에서 계산복잡도를 최소화하는 것이 매우 중요합니다.

1️⃣ COMER

1) ITC (Inference Time Complexity)

- Inference Time Complexity를 의미하는 단어

- Dialogue turn에서 state (slot-value)를 완료하기위해 inference를 수행해야하는 횟수

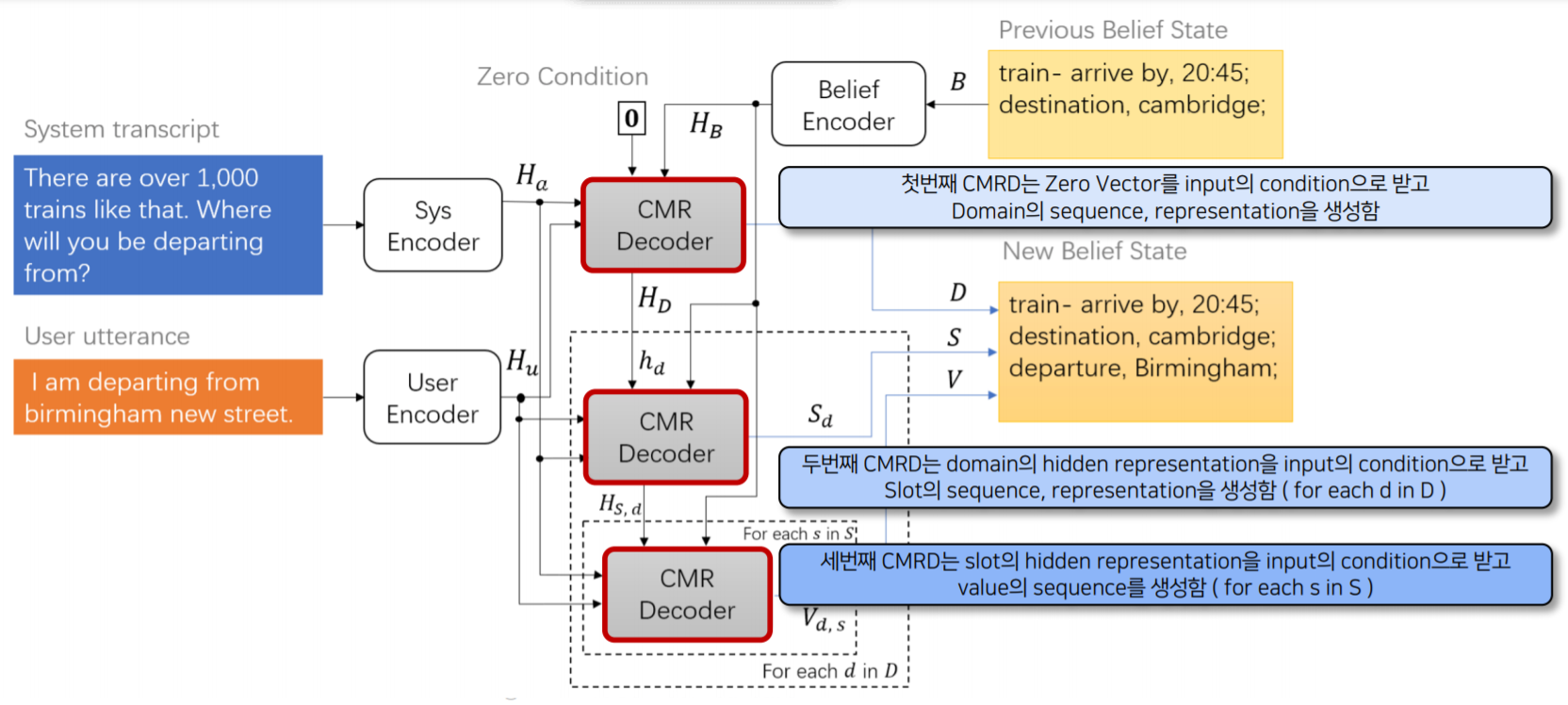

2) COMER Model

- COMER는 Seq2Seq framework를 적용하여 DST를 Sequence generation 문제로 접근했습니다.

- 3개의 Encoder와 3개의 hierarchically stacked decoder로 구성 되어있습니다.

- Single Value Assumption - 각 slot type은 해당 turn에서 slot value를 하나밖에 가질 수 없다는 가정

3) COMER Model - Encoder

- Encoder는 embedding layer와 BiLSTM을 포함

- Encoder는 User utterance, System utterance, (현재 Turn의) previous belief state를 input으로 받음

- User Encoder와 Sys Encoder는 고정된 BERT 모델을 Embedding layer로 사용함

4) COMER Model - Decoder

- Sequence Decoding을 위해 Conditional Memory Relation Decoder(CMRD)를 제안함

- CMRD는 Hierarchical sequence generation을 진행함

- 최종적으로 Generation을 마치면 새로운 Belief State로 Update됨

2️⃣ NA-DST

- 기존 DST 모델은 separate slot의 dialogue state를 예측함

- NA-DST는 Non-Autoregressive 구조를 활용하여 complete set의 dialogue state를 예측함

- Non-Autoregressive 구조는 parallel한 decoding이 가능하며, Generative DST의 latency를 낮춤

- Domain과 slot을 감지할 수 있으며, Token level의 slot들 사이의 종속성을 찾을 수 있음

1) Definition

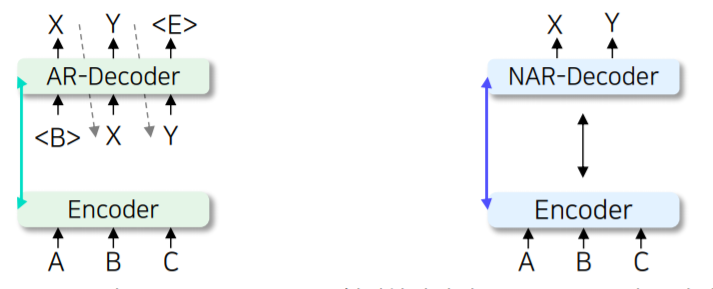

- AR Decoder vs NAR Decoder

- Fertility : Decoder의 input sequence를 형성하기 위해 input token이 복사되는 횟수 (Target Slot Value의 길이)

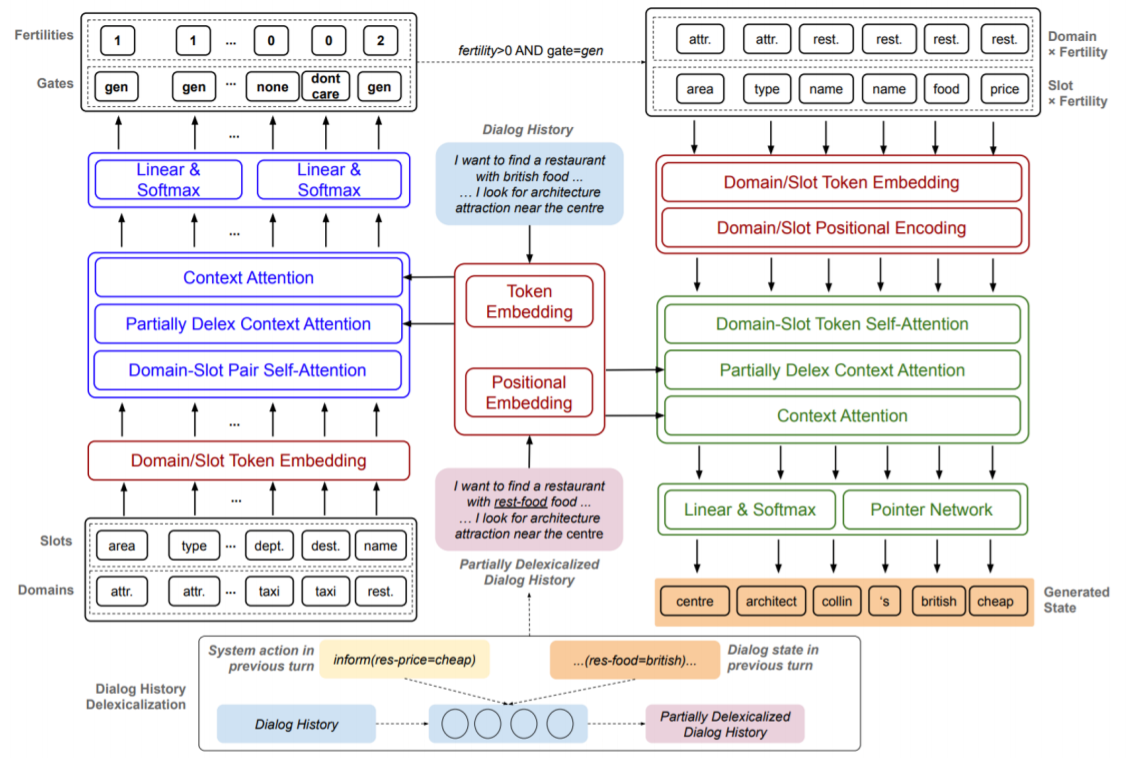

2) NA-DST Model

하나의 Encoder, 두개의 Decoder로 이루어진 모델

3) NA-DST Model - Encoder

- Encoder(Red)는 sequence of dialogue history, delexicalized dialogue history, domain ,slot tokens을 연속적인 representation으로 encoding함

4) NA-DST Model - Decoder (1) : Fertility Decoder

- Fertility Decoder(Blue)는 3가지 Attention mechanism을 사용함

- 이 mechanism은 domain-slot 쌍과 dialogue history에 대한 잠재적인 dependency를 학습함

5) NA-DST Model - Decoder (2) : State Decoder

- State Decoder(Green) 또한 3가지 Attention mechanism을 사용함

- Input으로 (Domain, Slot) x Fertility의 sub-sequence를 포함한 sequence를 받음

- Slot, value에 대한 Concatenation sequence를 output으로 decoding함

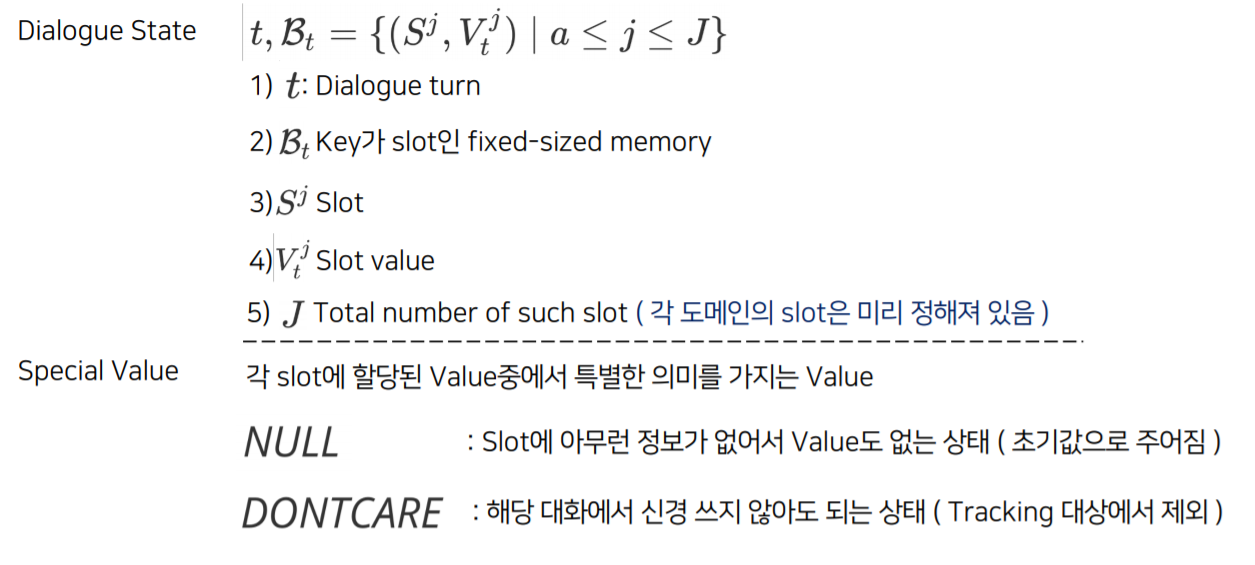

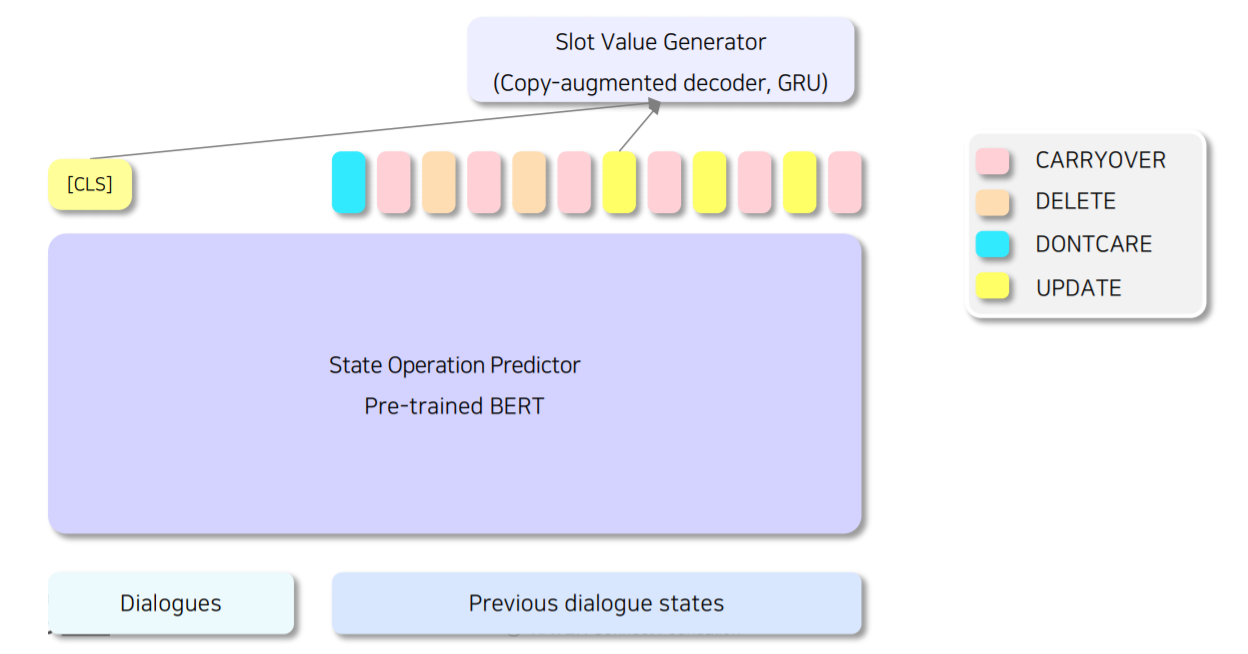

3️⃣ SOM-DST

- DST task를 2개의 subtask로 분리하여 효과적으로 slot에 해당하는 value를 생성함

- Task 1 : State operation prediction (Encoder 1개)

- Task 2 : Slot value generation (Decoder 1개) - Selectively Overwriting Memory

- 기존 모델 대비 효율적인 DST Model 구축

- Slot의 minimal subset (selective slot)만 가지고 value를 생성 할 수 있음

1) Definition

2) SOM-DST Model

State Operation Predictor와 Slot Value Generator로 구성된 모델

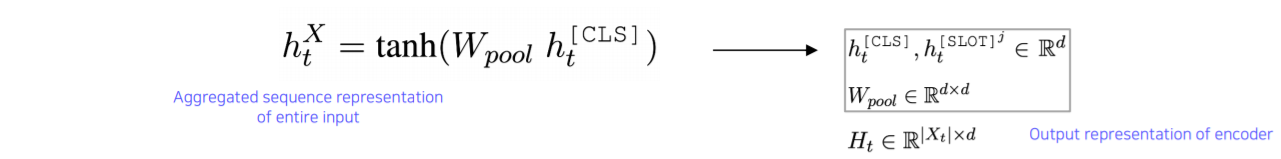

3) SOM-DST Model - State Operation Predictor

- Input Representation

- Encoder Output

- State Operation Prediction

- Process

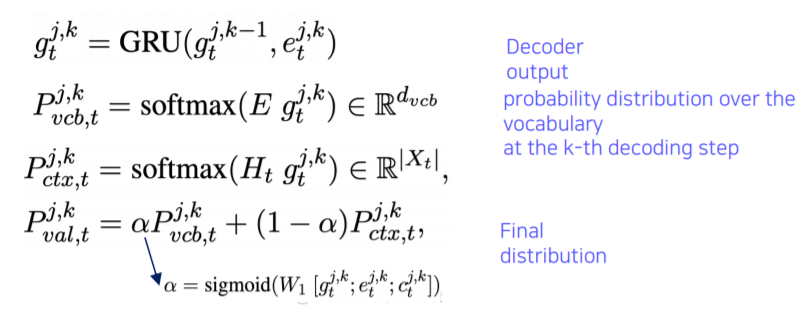

4) SOM-DST Model - Slot Value Generator

- Slot에 해당하는 Value를 찾기 위해 Generation task를 수행하는 Decoder (GRU 사용)

- 기존 연구는 모든 slot에 대해 generation을 진행해야 했지만, SOM-DST는 UPDATE Operation에 대한 value만 생성하면 되므로 효율적

- Training 과정에서는 GT Operation이 존재하므로 Encoder의 Output Operation을 사용하지 않음 Testing 과정에서 UPDATE operation slot index의 value generation 진행함 - Soft copy mechanism을 사용하여 final distribution을 생성함 (Pointer-generator)

- Process

'[P Stage 3] DST > 이론' 카테고리의 다른 글

| [Stage 3 - 이론] DST의 한계점 (0) | 2021.05.11 |

|---|---|

| [Stage 3 - 이론] Advanced DST Models (0) | 2021.05.11 |

| [Stage 3 - 이론] Hybrid Approach (0) | 2021.05.04 |

| [Stage 3 - 이론] Ontology-based DST models (0) | 2021.04.27 |

| [Stage 3 - 이론] Introduction to Task-Oriented Dialogue System (0) | 2021.04.27 |

Comments